作者 | 程茜

编辑 | 漠影

蚂蚁集团这波操作大圈粉!

智东西10月28日报道,10月25日,蚂蚁集团在arXiv上传了一篇技术报告,一股脑将自家2.0系列大模型训练的独家秘籍全盘公开。

今年9月至今,蚂蚁集团百灵大模型Ling 2.0系列模型陆续亮相,其万亿参数通用语言模型Ling-1T多项指标位居开源模型的榜首;Ling-mini-2.0总参数160亿,每个Token仅激活14亿参数;Ling-flash-2.0总参数1000亿、激活仅6.1B,性能媲美400亿级别参数模型……

这些模型的表现,标志着大模型发展从单纯堆参数迈向以高效方式实现智能的新阶段,而这一转变的核心支撑正是Ling 2.0技术体系,此次蚂蚁技术报告对此进行了全盘解读。

Ling 2.0的核心亮点清晰聚焦:依托高稀疏度混合专家设计、推理导向的数据流水线、多阶段对齐策略,以及基于FP8的万亿级训练基础设施,无一不是在为通用推理模型搭建具备可扩展性的坚实技术底座。

当我们将目光放大至整个行业,可以发现,大模型的竞争力正向用用最少的资源解决最多的场景问题转变,而Ling 2.0面向模型架构、预训练、后训练、基础设施各个环节的深度融合创新,正在为其提高切实可行的技术路径。

在这一背景下,围绕Ling-min-2.0、Ling-flash-2.0、万亿参数非思考模型Ling-1T三款模型的具体性能,以及蚂蚁新技术报告,我们将拆解大模型时代当模型架构、训练数据、训练策略与基础实施深度融合后,模型智能会如何飞跃。

技术报告:https://arxiv.org/abs/2510.22115

Hugging Face开源主页:https://huggingface.co/inclusionAI

一、每一次激活都提升推理能力!架构、预训练、后训练、基础设施全栈融合创新

参数规模达数千亿乃至万亿参数的超大规模模型加速涌现,其在大模型产业中的重要性与日俱增。

但伴随模型向更高参数规模、更强模型能力突破的同时,仍面临模型训练效率与成本的平衡、模型推理能力提升、长上下文处理、模型性能与评估体系迭代慢等多重关键问题。

针对这些痛点,Ling 2.0的核心解法就是“让每一次激活都提升推理能力”,从而实现在稀疏激活下最大限度地提高推理精度和效率。而这一技术优化的关键也就是推理环节的效率与精度兼顾的痛点,使得大模型训练在保证计算资源高效利用的同时,直接推动推理能力的提升。

大模型的实际性能表现,是衡量其技术路径优劣最直接、最有力的证明。如今,基于Ling 2.0,蚂蚁集团已经发布三款不同参数规模模型,160亿参数规模的Ling-mini-2.0、1000亿参数规模的Ling-flash-2.0以及万亿参数模型Ling-1T。

在效率层面,Ling 2.0系列模型中,Ling-mini-2.0每Token激活参数仅14亿,其性能就可媲美百亿参数级稠密模型,Ling-flash-2.0每次推理激活参数61亿,就可媲美400亿级稠密模型,激活计算效率约7倍。Ling 2.0模型实现了以更低计算成本,实现更高性能回报。

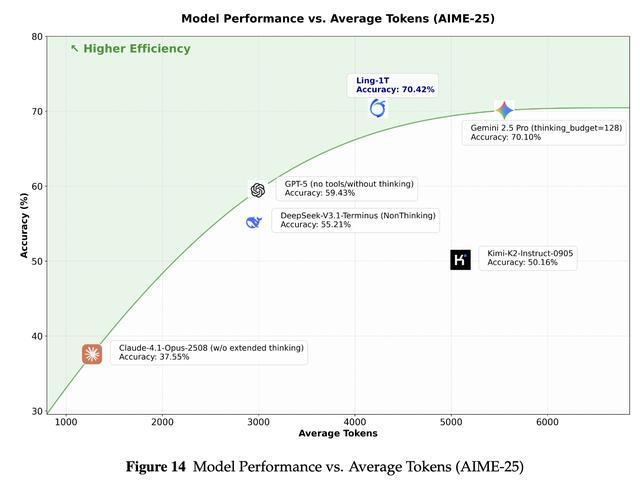

推理性能上,万亿规模模型上,Ling-1T每次推理激活约510亿参数,在2025年美国数学邀请赛AIME benchmark中,其突破了推理准确率与推理长度的帕累托边界,实现既支持更长文本、更多轮次的高效思考,又能保证复杂任务下答案的精准求解,尤其在数学与编程任务中优势明显。

与此同时,这三款模型还展现出了一致性,Ling 2.0系列模型参数规模从百亿到万亿,性能也随之稳步提升,这一结果直接验证了其架构设计与训练策略的可扩展性。

模型的实际表现证明,Ling 2.0 技术正在解决大模型推理效率与精度难以兼顾的核心矛盾中,持续创造价值,让每一次参数激活都服务于推理能力提升,避免了无效计算。

通过对蚂蚁这份新发技术报告的深度拆解,我们得以完整看清这一技术路径的底层逻辑和关键原理。

二、模型架构:高稀疏MoE与Ling缩放定律

首先是模型架构,其作为核心支柱直接决定了模型性能上限。

在Ling 2.0中,研究人员采用了统一的MoE基础架构,然后集成aux-loss-free负载均衡策略和多Token预测(MTP)进一步提升性能,并通过Ling scaling law进行精准外推扩展。

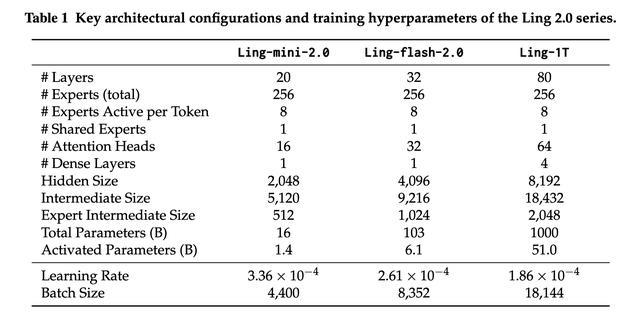

具体来看,其基于高稀疏度、细粒度的设计,使得每个模型配置256个路由专家,8个激活专家和1个共享专家,整体激活率约为3.5%。同时将三个模型的初始层分别指定为1层、1层和4层稠密层,这种方法可以在保持模型性能的同时减少总参数量,并提升路由平衡性。

Ling 2.0系列的模型架构配置

底座搭建完成后,研究人员进一步通过设计优化提升其效率、性能、可扩展性。

Ling 2.0的路由均衡策略遵循与DeepSeek-V3类似的设计,其无辅助损失均衡策略可同时促进专家专业化和负载均衡,并应用路由器门缩放提高训练稳定性。

同时,Ling 2.0还原生集成MTP作为辅助训练目标,为每个模型规模引入一个MTP层,并将MTP损失权重设置为0.1,通过在Megatron训练框架内为MTP模块实现细粒度的流水线并行(PP)划分,以降低MTP的性能开销。

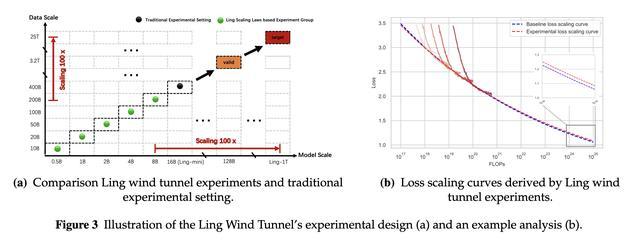

研究报告指出,研究人员最初就将训练万亿参数模型作为长期目标,因此从一开始就制定了Ling scaling law用于指导超参数与架构的选择。其关键作用包括,确定Ling 2.0的超参数与架构配置,确保架构效率接近最优水平;提供标准化流程,仅需全量训练计算成本的 1%,即可验证针对Ling 2.0的新想法与新兴技术。

这就使得其计算结果可以更加可靠地被外推到规模超100倍的计算场景中,让万亿级规模的模型落地能更加高效推进。

其制定的统一EL缩放定律整合了计算预算(C)、激活率(A)和专家粒度(G)的影响:

研究人员的实验结果显示,与传统消融实验相比,Ling风洞实验(低成本实验评估框架)的成本效益更高,其总计算成本仅为传统方法的35%。

Ling风洞实验设计图(a)及实例分析(b)

三、预训练:20T高质量数据集与多阶段训练策略

预训练相当于为大模型打下扎实的基础认知,其核心在于让模型学会通用知识和推理,同时为之后完成下游任务的快速微调、可扩展性打基础。

因此,数据集的质量以及到底要怎么训练就是这一阶段的关键。

在数据选择与准备阶段,Ling 2.0的目标是构建高效的数据处理基础设施和管理语料库,广泛涵盖高质量的通用数据,包括但不限于常识、代码、数学、多语言内容等。

其数据种类多元化,既包括从网页、书籍、论文和维基百科等海量多样化数据集中获取到的常识数据,还包括主要增强通用推理能力的Ling代码语料库和数学语料库,以及多语言数据、长上下文数据。

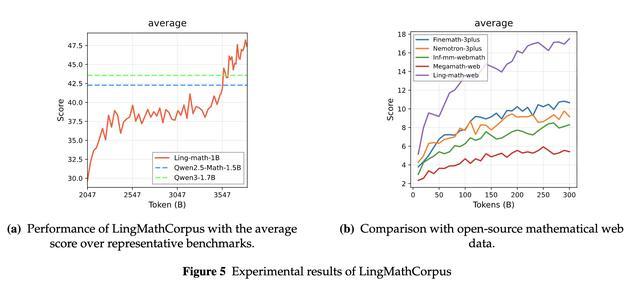

Ling数学语料库实验结果

训练策略是让数据最大程度发挥价值的另一关键。

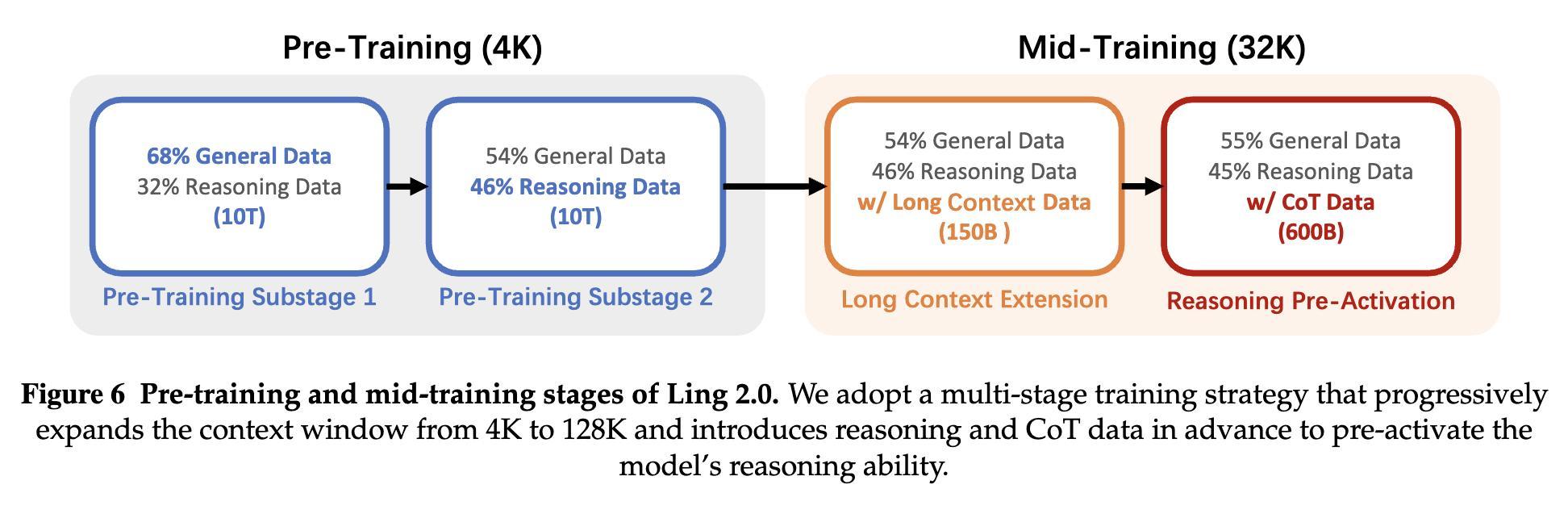

在此基础上,研究人员在预训练和中期训练阶段采用了多阶段训练策略:在大规模通用语料库上进行通用预训练;在中等规模、特定任务语料库上进行中期训练。

Ling 2.0的预训练和中期训练阶段

通用预训练阶段,Ling 2.0消耗了大量数据,以确保整体性能的稳健性;中期训练阶段其将上下文长度扩展至128K,并通过引入思路链(CoT)数据预先激活模型的推理能力。

此外,在模型训练中期,提升训练有效性的关键手段是学习率(LR)衰减,但该方式存在明显短板,既限制了训练过程的灵活性,又额外增加了调优开销。为解决这一问题,Ling 2.0系列创新采用WSM(预热-稳定-合并)调度程序,其核心改进是用检查点合并替代传统的LR衰减,能提供更高的灵活性和可扩展性。

为了让预训练的质量更可靠,研究人员将预训练从结果评估变成全流程可控,也就是不仅评估最终模型,还会在整个训练过程中持续监控基础模型的基准性能。

这些综合优化设计之下,Ling 2.0不仅可以基于高质量数据拔高基础模型能力性能,还可以进一步降低其训练与落地的成本。

四、后训练:分层优化,编程、推理能力优于多个主流模型

兼顾快速日常查询和复杂需求准确应对,是Ling 2.0后训练阶段的关键。

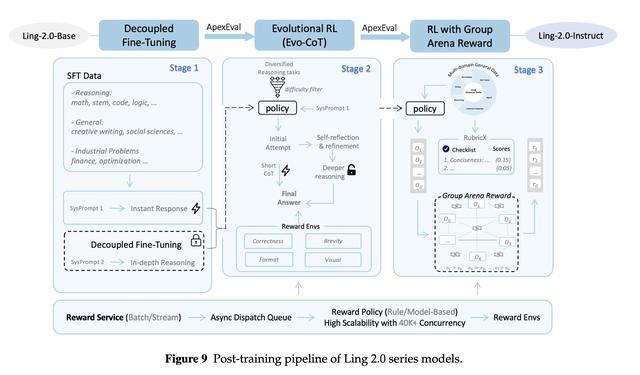

在这一层,研究人员采用了分离训练的监督微调、进化推理强化学习、人类偏好一致的群体竞技奖励结构化三阶段方法,并将其建立在可扩展、高吞吐量的奖励计算基础设施之上。

Ling 2.0后训练流程

首先在第一阶段,其引入了一种通过差异化系统提示构建训练数据的监督式方法解耦微调(DFT),使模型能够建立专用的深度推理模式。

第二阶段,Ling 2.0提出进化思维链(Evo-CoT),可以向反射级非思维模型中灌输自适应推理,使它们能够根据问题的复杂性扩展推理深度。

第三阶段,研究人员设计了群体竞技场奖励(GAR)机制和扩展领域规则RubriX,提升主观任务优化的稳定性, 最终实现技术层面准确、且能自然贴合用户意图的生成效果。

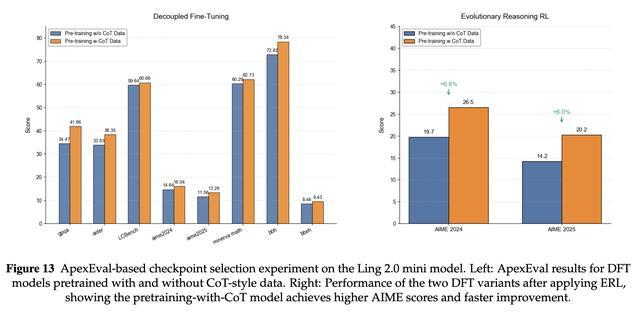

这一阶段,研究人员也充分引入了评估策略,其提出ApexEval,以获得强化学修训练的最佳检查点,从而有效地初始化强化学习。

基于ApexEval的Ling-mini-2.0模型检查点选择实验

其评估结果显示,Ling-mini-2.0、Ling-flash-2.0和Ling-1T在涉及编程、数学和推理等任务上的表现优于大多数业界领先模型,在AIME 2025评测集上,Ling-1T在推理精度和效率上取得了比DeepSeek-V3.1、Kimi-K2、gemini 2.5 pro更优的平衡。

五、基础设施:面向万亿级模型训练进行工程优化

Ling-2.0算法架构的创新提供了大模型低成本扩展的理论路线,但与之匹配的基础设施能力,直接决定大模型能否训得出来、跑得起来、用得好。其论文中提到,在没有任何工程优化的情况下,这种高度稀疏的MoE架构在性能上并不优于密集模型。

然而当下构建可支持万亿参数高效训练的基础设施系统面临显著挑战,核心难点在于难以同时平衡成本控制与训练效率提升两大需求。

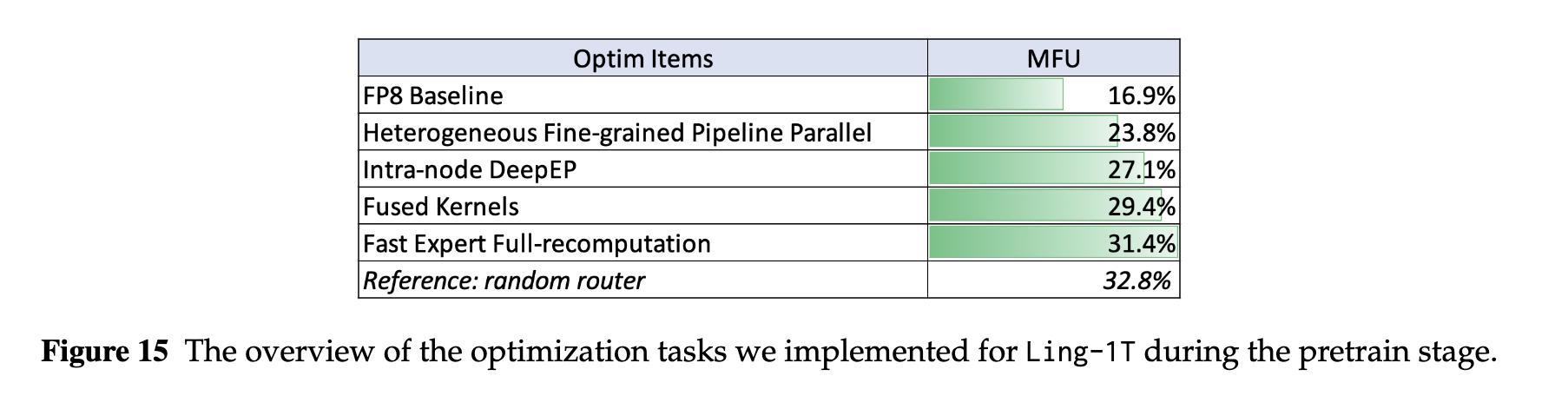

因此,Ling 2.0针对此进行了系统级的工程优化,包括全量FP8训练、异构细粒度流水线并行、分布式训练框架优化,以及基于4C原则构建大模型软件工程。

具体来看,Ling 2.0采用细粒度的块级FP8量化策略,激活和梯度以[1, 128]大小的块进行量化,权重以[128,128]大小的块进行量化。研究人员还针对交错1F1B流水线策略存在的挑战对PP框架进行了优化。

除了FP8训练和异构调度,研究人员针对分布式训练框架进行了包括节点内DeepEP、引入多种融合算子、使用完全重新计算、长上下文训练等的优化,以增强Ling 2.0训练的性能和稳定性。

在Ling 2.0模型训练和分布式框架开发过程中,框架开发经常成为模型训练的瓶颈,严重时甚至会影响训练效果,因此,研究人员进一步引入正确、一致、完整和协同设计的4C原则,以保证模型训练在降低相关成本的同时,能提高开发效率和交付质量。

最后在模型评估层面,研究报告中,其基于OpenCompass重新设计了整个评估流程,与原始OpenCompass相比,每个检查点的总评估时间减少了2/3以上。

这一系列的研究结果证明,MoE模型可以通过架构、训练和基础设施方面的协同创新,同时提升推理能力和计算效率。

结语:蚂蚁集团开源之路,开启大模型高效推理时代

当前大模型领域正从参数竞赛转向效率与性能的平衡,蚂蚁集团此前开源了诸多模型从轻量推理模型到万亿参数模型,Ling 2.0的技术报告又通过诸多技术细节,清晰展示了模型规模与效率并非对立的技术路径。

从其结果来看,这一策略为后续模型开发提供了可借鉴的范例,推动行业从单纯的参数竞赛转向更注重效率和性能的发展路径。