眼看就要到春节了,很多团队已经开始放慢节奏,但 AI 圈还是一如既往地卷。就在不少人以为“该发的模型都发完了”的时候,新模型还是一波接一波往外上,完全没有停住的趋势。

这段时间你会发现一个很有意思的现象:一边是各家都在 AI 入口上做很重的营销动作,抢入口、抢用户心智、抢使用场景;但另一边,底层模型的更新速度其实一点都没慢下来。

厂商自己也很清楚,只靠入口包装和营销声量,是撑不住长期竞争力的,模型能力本身必须持续往前推。

最近,字节跳动又放出了一张新牌:新一代视频生成模型 Seedance 2.0 正式发布,把视频生成这条线往“更可控、更连贯、更像真实镜头语言”的方向又推了一步。值得注意的是该大版本号模型,离前一代支持音视频联合生成的模型 Seedance 1.5 Pro 的发布日期只过去了 2 个月。

入口在打仗,模型在加速,两条线同时在跑,而且都没打算等对方。

下面,我们也完整实测了一波 Seedance 2.0。

先说一下,这次我是直接在「即梦」里用的 Seedance 2.0,下面讲的体验也都基于这个平台。

Seedance 2.0 这版主打一个点:参考能力更全面。跟上一代的音视频模型 Seedance 1.5 Pro 比起来,它现在对多张图片、多段视频一起参考的支持更强,用起来也更顺手。

另外你也能看到一个趋势:不只是做视频生成的模型在加强“参考视频”这件事,像 Kimi 2.5 这种通用大模型,也开始强调可以参考视频内容来生成结果,大家都在往这个方向走。

01

苹果风格商品宣传

我们一开始,就先做了一组素材:运动品牌风格的人物模特,加上运动手表这种实物产品,一起拿来做测试。

然后我又上传了一支很经典的 Apple Watch 官方宣传片。这种片子本身就是多镜头结构,既有人物镜头,也有产品特写,很适合拿来当参考素材。

现在在即梦里,你基本不用写很复杂的提示词,按它那个很直观的提示方式来就行。直接告诉它:参考这支视频的镜头节奏和风格,生成一条新的运动手表广告。

同时把主角换成我自己的图片,把商品也换成我准备好的产品图。整套流程很直接,就是选参考视频 + 选人物图 + 选商品图,然后让模型去生成一条新的广告片。

生成这类视频的时间会比较久,而且积分消耗也不低。比如两张图片加一段参考视频,同时都参与参考的话,做一条 15 秒的视频,基本要花接近 200 积分。

不过成片出来之后,你能明显感觉到质量是在线的。整体真实感很强,模特在公路上跑步时的光线变化、头发上的反光、脸部的受光细节,都做得很到位,看着不会假。

还有一点:我其实没有给它一个完整的故事结构,只是给了参考素材和目标类型。最后的视频节奏基本是它自己排出来的。

片子里出现的商品,主要就是我给它的那只手表。它里面有两段镜头是专门切到手表上的,而且还加了动效。

整体看下来,画面元素基本没什么大问题。比较常见的坑还是那个:数字和中文偶尔会乱写,会有点“AI 幻觉”。

右下图片那个转场,它会有一个滑动手表的动作。我专门截了几帧去看,很多帧里文字其实是正常的,只是在滑动的那一瞬间容易出错。这个表现跟上一代比,确实进步很明显。

你要是认真去逐帧截图看,会发现细节也比较到位。女模特手臂上的纹理、手上的细小汗毛,是能够看清的。

02

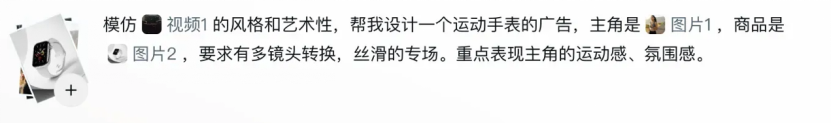

“跨风格整合”的财神拜年

因为它的动效表现确实不错,我就又多做了一组测试。我新生成了一张新春财神抱着金元宝的图,再加上一张美剧风格的恶灵骑士角色图,然后把这两张图一起丢进去当参考素材,让它按这个方向继续生成视频。

我给它的目标其实很简单:先让财神出场,背后是一堆元宝和金币,在发光、在晃动;接着恶灵骑士骑着摩托冲进画面;然后变成财神骑着这辆摩托直接开走;最后闪出一帧画面,打上“新春快乐”和具体日期的中文与数字。

成片看下来,开头恶灵骑士那一段,AI 感还是偏重一点,能看出来是模型在“拼”画面。不过从财神和道具之间的互动,到表情变化,再到动作衔接,比以前顺了不少。

还有一个小规律我这次也注意到:如果画面里放的是那种比较大的艺术字,Seedance 2.0 出错的概率会低很多。

如果是一张图片里有多个主体,然后让镜头一个个扫过去,这种场景我也测了一下 Seedance 2.0 的表现。

03

多主体镜头

我做了一张图:五个小动物穿着不同礼服,一起坐在同一条长椅上。主体多、造型差异大,还都在同一画面里,这种情况其实挺考验模型的镜头理解和主体保持能力。

我当时的提示词设计很直接:让画面里所有小动物一起跳舞给大家拜年,镜头要一个个扫过去。每扫到一个角色,就在它的动作上停一下,给慢镜头和特写。

这个视频主要在考一件事:镜头逐个扫过时,角色的出现顺序要对。也就是视频里的出场顺序,要和原图里小动物从左到右的顺序一致,这点很看一致性能力。

从生成结果来看,Seedance 2.0 在画面质量和整体一致性上都还不错。不过这条视频我也反复跑了三四次才选到比较满意的版本。动作质量普遍很高,但还是会有顺序问题,比如熊猫和兔子的位置被对调,这种情况还是会出现。

但如果只看角色本身和动作表现,这一版确实提升很明显。每次镜头停在单个角色上时,毛发细节、质感、真实度,还有镜头之间的切换,都处理得比较顺。

04

宇航员与 3D LED 屏里的猫

左边是一张十字路口的大型 3D LED 屏画面,里面有一只猫,尾巴是从屏幕里伸出来的;右边是一张很经典的宇航员图片。

提示词是:让这个宇航员走进十字路口,在路口下面停住,把头盔面罩打开,再戴上墨镜,看向 3D LED 屏里的猫,然后整个人愣一下,周围街道人来人往。

从最后生成的视频来看,整体效果其实很不错。尤其是宇航员走进路口那段,你能看到周围行人和车辆都是在动态变化的,没有那种很明显的错乱感,看起来会比较顺。

小问题也有,就是屏幕里的猫还是显得有点呆,灵动感差一点。整体能用,但这个角色的表现还有提升空间。

05

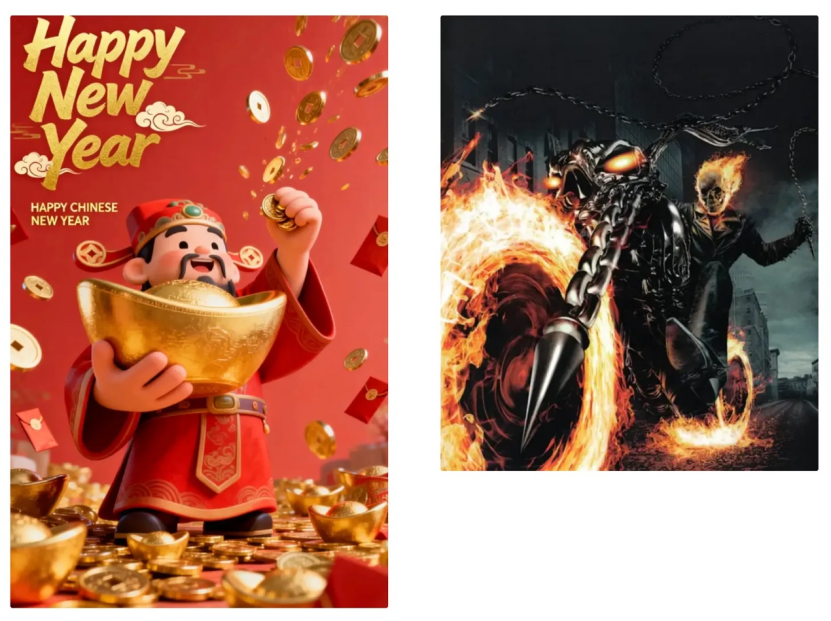

多人物 INS 风剪贴画

我给 Seedance 2.0 的目标也很明确:人物不要变,背景不要变,画面里的这些男性角色都要保留下来,只是在这个基础上,让他们一起跳起来动起来。

这个任务其实挺难的。按以前的经验,一张元素很多、结构很复杂的图,光是做静态生成就不太稳,很容易出错。要是在视频里再让这些剪贴画人物动起来,还要跳舞、互动,就更容易把周围元素带乱。

所以一开始我自己的预期也不高,会觉得出错的概率不小。

我给的提示词:这是一张有多个男性角色的剪贴画,背景和版式全部保持不变,只让人物跳舞;节奏偏搞笑、偏抽象;人物之间要有互动动作,比如握手、击掌。

最后生成出来的视频,其实跟提示词对得挺准。画面里的文字没有被改动,不管是上面的主标题,还是下面的小块文字,都保持原样。整张图里一共七个角色,他们之间都有互动,而且基本是在同一个节奏上跳舞。

而且你仔细看细节会发现:这些角色就算把后面的剪贴画文字挡住了,在遮住、再淡出的那一下,文字本身也没有被改掉。

06

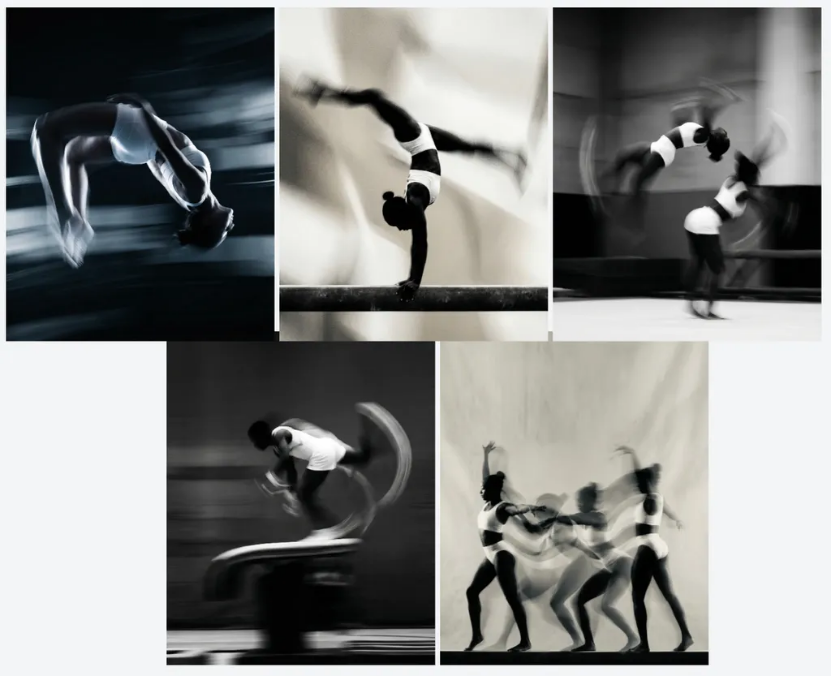

NIKE 风运动员剪影

最后一个案例,我用的是一位体操运动员运动时的模糊剪影。我给了它一套 5 张参考图,每张都有很明显的动态拖影,构图也很极简,没有 logo 和文字,但整体质感很强。

我当时对 Seedance 2.0 的要求也比较高:希望它能把这种动态拖影的感觉保留下来,整体风格往运动广告片那边靠,像那种品牌宣传片的质感,再简单配点字,就能直接发到短视频平台。

这个目标其实不低,但最后生成的效果还是挺可以的。

你能看出来,它在结构和节奏上是有主动安排的,不是那种很死板的处理方式。镜头切换也不生硬,没有走老路:不是简单把一张图变成动图,再在几段动图之间硬切。

这种老式做法在早期的视频模型里很常见,这一版明显更自然一些。

音乐这块我其实什么参考都没给,也没写相关提示词,但它最后配出来的音乐,和整条视频的节奏还挺合拍的,不是很违和。

有几个镜头它还会主动给慢镜头特写,比如倒数第二个镜头,就明显放慢了节奏,把动作拉出来单独展示。我还专门截了一帧图来看,那一刻的画面,和我上传的参考图几乎是一样的。

同时你也能看出来,它为了把前后镜头接顺,会把这张参考画面往前多补一点内容,也往后多延一点动作,这样前后过渡就会更自然,不会突然断掉。

最后简单收一下:整体看下来,Seedance 2.0 在叙事节奏、镜头切换,还有对参考图片和参考视频的一致性保持上,都比上一代音视频模型强了不少。

问题也还是有的,比如画面里有很小的文字,或者很细的小元素,在动态变化的时候,还是会偶尔出错。不过出错的频率,确实比上一代低了很多。与此同时,单个视频的生成时间往往非常漫长,积分的消耗也非常大。

对字节的平台来说,这是内容供给效率的提升,毕竟字节已经将该模型全面下发到旗下各个 AI 内容创作平台,例如即梦、CapCut(剪映)等等。

从更现实的角度看,视频生成模型这条线,已经快速进入产品化和商业化验证期。谁能把生成质量、生成速度、可控性和接入成本一起压到可用区间,谁就更有机会进入真实内容生产链路。

可以说,春节前这一波密集发布,更像是新一轮视频 AI 竞速的发令枪。接下来,整个 AI 视频模型领域的竞速将会以肉眼可见的速度,迅速“开卷”。