带上

她的眼睛

iPhone 的零件自研比例,又要上一个新高了。

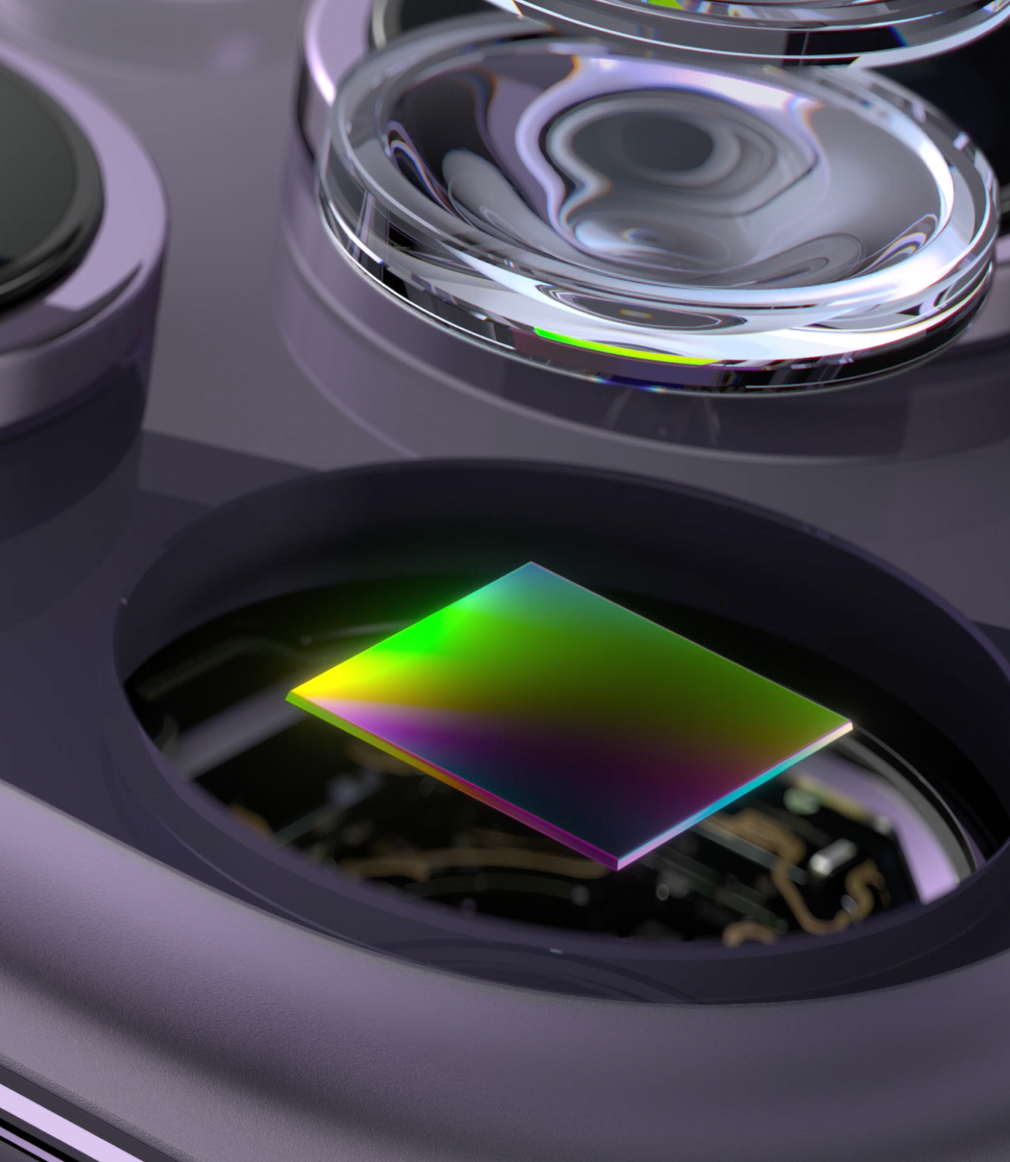

根据供应链消息和部分泄露信源,一款苹果自研的相机图像传感器,在近日进入了开发验证(developmental test)阶段。

如果消息属实,从苹果的历史研发节奏来看,自研图像传感器有大概率会在未来几年落地,实装到 iPhone、iPad 甚至带有摄像头的 Vision 产品线中。

这是继处理器和基带之后,苹果在追求软硬件深度自研/集成上,迈出的又一大步。

图|Lux

影像全自研,从传感器开始

如果你用过这几年的国产超大杯影像旗舰,再次拿起 iPhone、启动那颗 5 倍长焦时,大概率会由衷感叹一句:iPhone 的拍照怎么还是老样子啊?

能搞定要求更高的录像,却在最简单的静态照片上用户体验严重滞后,这背后大概率是苹果的思路出了问题。

我们目前可见的是,iOS 26 测试版中,iPhone 16 Pro Max 相机的 DeepFusion 锐化程度相比之前变得更收敛了,至少说明苹果还是在持之以恒的优化算法的。

使用 iPhone 16 Pro 拍摄

问题是,仅靠算法的提升终究有限。想要更加根本地解决这个问题,苹果可能还要进一步提高 iPhone 影响部门的自研比例。

而自研图像传感器,可能意味着苹果与索尼从 iPhone 4s 开始,保持了近十五年的合作关系将迎来巨大变化,

目前,由于苹果的自研图像传感器仍然处在内部测试阶段,能够从上下游获得的泄露消息并不多,但有一项指标是较为确凿的:

苹果希望提升的主要方向之一,是实现超高的宽容度——据称拥有「接近人眼的动态范围」。

动态范围不足(左)与高动态范围(右)的区别|Halide

能够帮助达成这项指标的,则是一项这几代 iPhone 缺席的技术:横向溢出集成电容(lateral overflow integration capacitor),简称为 LOFIC,是一个在像素之外的独立小电容。

如果把手机传感器上几千万个像素感应光信号的过程,比喻为几千万个水杯接水的话,那么动态范围就是水杯能接住的最少水量和最大水量的差值。

这个差值越大,说明传感器能够同时捕捉到的暗部和亮部信息越多。现在的手机通常拥有 13~15 档动态范围,而经过几亿年进化的人眼则大约拥有 20~30 档动态范围。

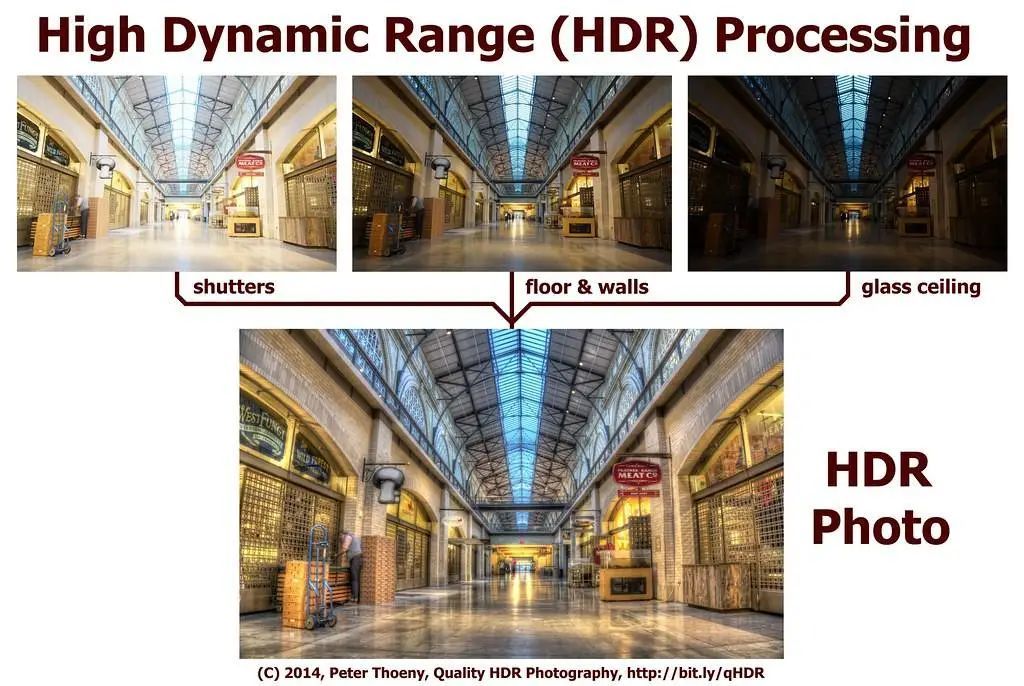

这相差的十几档动态范围,就是很多时候我们能够看到很漂亮的光线场景,手机却拍不出来的原因。哪怕用相机也需要多次曝光再合成后,才能实现接近肉眼看到的效果。

而 LOFIC 的作用,相当于在水杯旁边又放了一个小杯子。当水量太多(光线太强)时接住横向溢出的水(过曝的信息),抢救下了这些以往会直接丢失掉的亮度信息、从而能够承载更多档位的动态范围。

此外,LOFIC 的优势还包括可以实现单帧 HDR 照片,以及减少强光在传感器上导致的光晕。

传统多帧合成 HDR 方案需要拍摄长中短曝光的照片再合成,成像速度很难提高|Flickr

通过让像素记录暗部和中调信息、电容记录高光信息,LOFIC 可以实现只需要拍摄一张照片,就能够记录暗、中、亮部信息,无需像传统的多帧合成方案那样拍摄几张不同曝光的照片,可以非常显著提高 HDR 照片的拍摄速度、减少拖影和重影。

而苹果此次自研的图像传感器,据爆料可以达到 20 档动态范围,虽然距离人眼仍然有几个量级的差距,但比起目前市面上其他使用了 LOFIC 技术的传感器,仍然算是「宽容度最接近人眼」的。

赶了个晚集

然而问题就在这里:LOFIC 虽然听上去非常高端,但并不是什么特别新的技术。有关 LOFIC 原理的论文早在 2019 年就已出现,而已经用上的产品也在今年内开售了。

这个已经用上的产品,就是我们(以及苹果)的老朋友豪威集团(OmniVision Group)旗下的 OV50K40 传感器,并且已经在荣耀 Magic 6 至臻版机型上实现了落地:

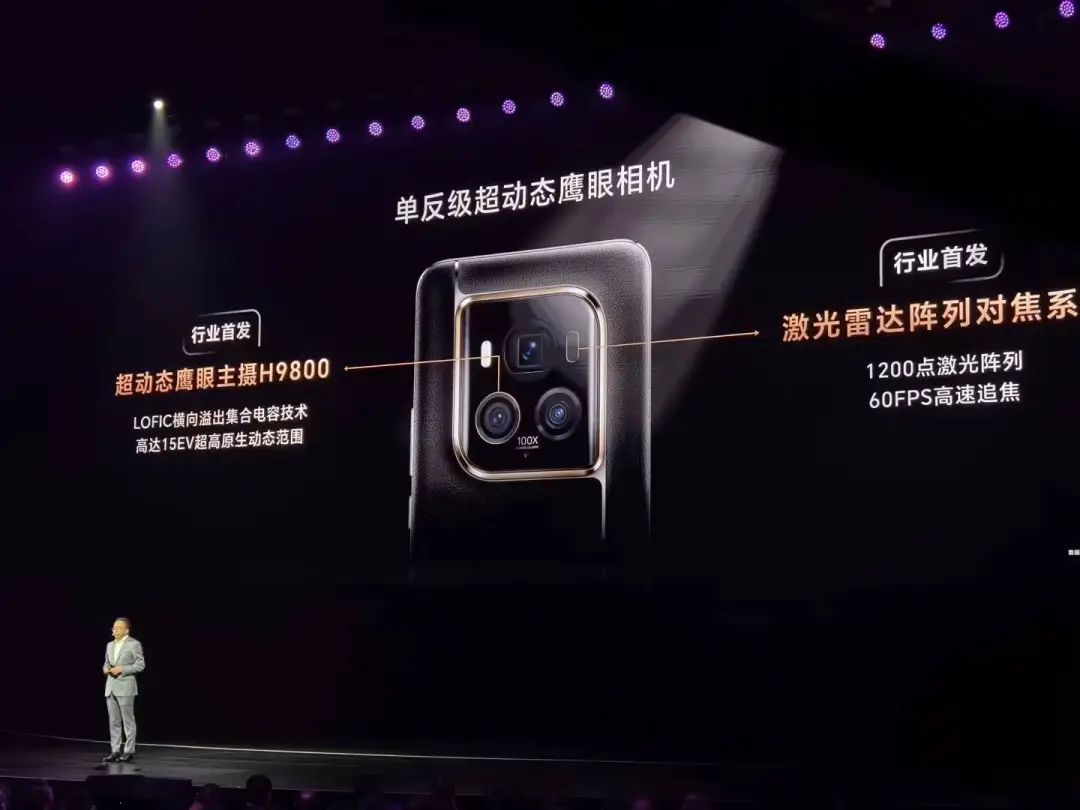

荣耀的 H9800 传感器就是定制版的 OV50K40,官方宣称动态范围达到了 15 档

目前,所有搭载了豪威 TheiaCel 技术的传感器,理论上就都有了 LOFIC。

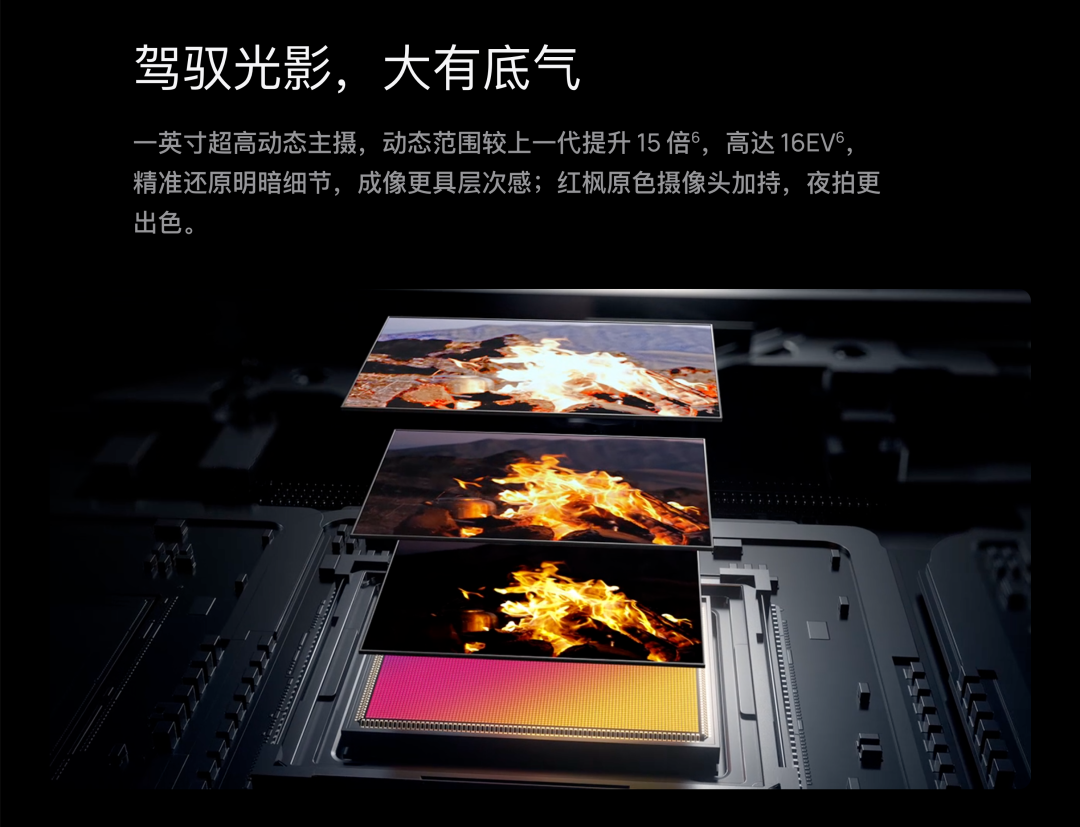

这其中除了荣耀的 H9800 之外,也包括华为 Pura 80 Ultra 主摄那颗 16 档动态范围的 OV50X 传感器。

虽然用着 LOFIC 技术,宣传页面展示的依然是多帧合成 HDR|华为官网

不过根据现有的资料,小米与豪威定制的光影猎人 900 系列传感器是没有 LOFIC 的,而是基于双原生 ISO 的双转换增益(DCG)HDR 方案。

在此之前,LOFIC 技术更多其实是被用在监控摄像头、汽车视觉方案里面(如小鹏 P7 和 G9 的视觉辅助方案)、LOFIC 的高动态范围原理对于这种需要兼顾巨大明暗反差、且对快门速度要求极高的场景是很有帮助的——

巧合的是,手机的拍摄场景,至少有一大半落在了这个区间。

这是一张我七月初旁听中国留美经济学会年会开幕式时拍的照片。当时林毅夫教授讲台的位置的灯光很暗,背后又是一块巨大的 LED 灯墙——如果没有手机上的强力 HDR ,这个角度拍过去就只能得到一张剪影:

从原理上讲,LOFIC 简直就是为这种动态范围要求极高的场景而生的。如果当时的传感器有更好的单帧 HDR 能力,林毅夫教授的手就不会因为多帧合成 HDR 而导致模糊了。

而苹果此前一直使用的索尼 IMX 系列传感器,却在动态范围方面迟迟没有什么动作。

iPhone 16 Pro 系列的主摄传感器 IMX903 虽然通过双层晶体管像素技术实现了非常高的原生动态范围,但受限于手机 CMOS 的面积和体积,其所带来的边际收益已经不比当年了。

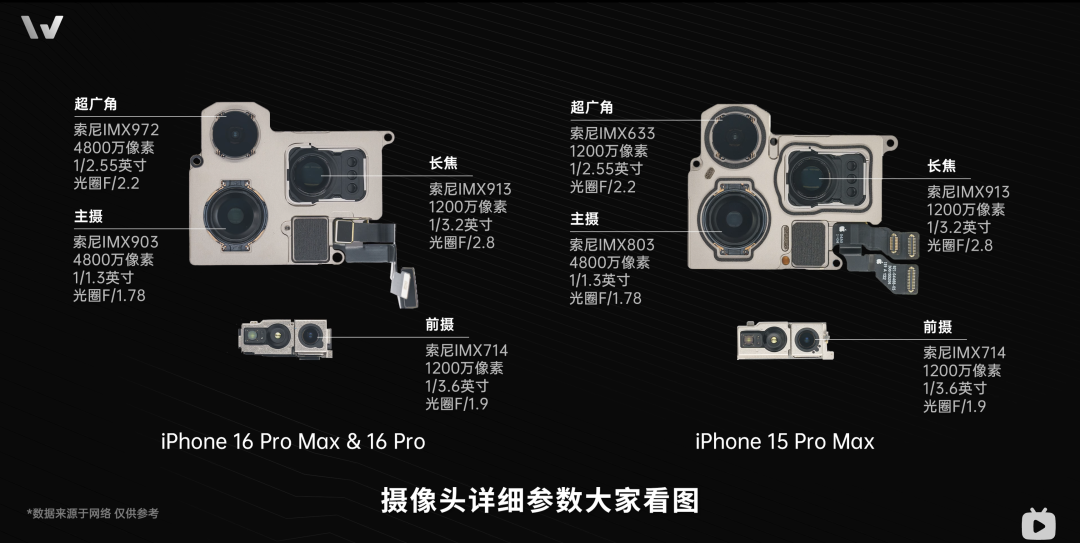

iPhone 影像部门基本被索尼「霸占」

图|@微机分WekiHome

还原人眼,手机影像回归本真

从另一个角度看,本次苹果传言要自研图像传感器的消息,在某种程度上也是一个新的信号:

在影调和长焦之外,苹果正在计划开辟一条新的赛道——还原人眼的观感,而非单纯的颜色。

这是一条非常有意思的赛道。

高动态范围(HDR)作为苹果近五年来持续发力的领域,从摄影原理的角度来说,甚至可以看作是一种比「长焦拍得到」和「颜色还原准」都要更基础的方向。

需要注意的是,这里的 HDR,并不是指你的手机屏幕可以在显示照片的时候激发更高的亮度,而是图片内部本身记录的亮度层次信息的多寡。与分辨率、位深度(bit depth)一起,动态范围是决定照片信息丰富程度的基石之一:

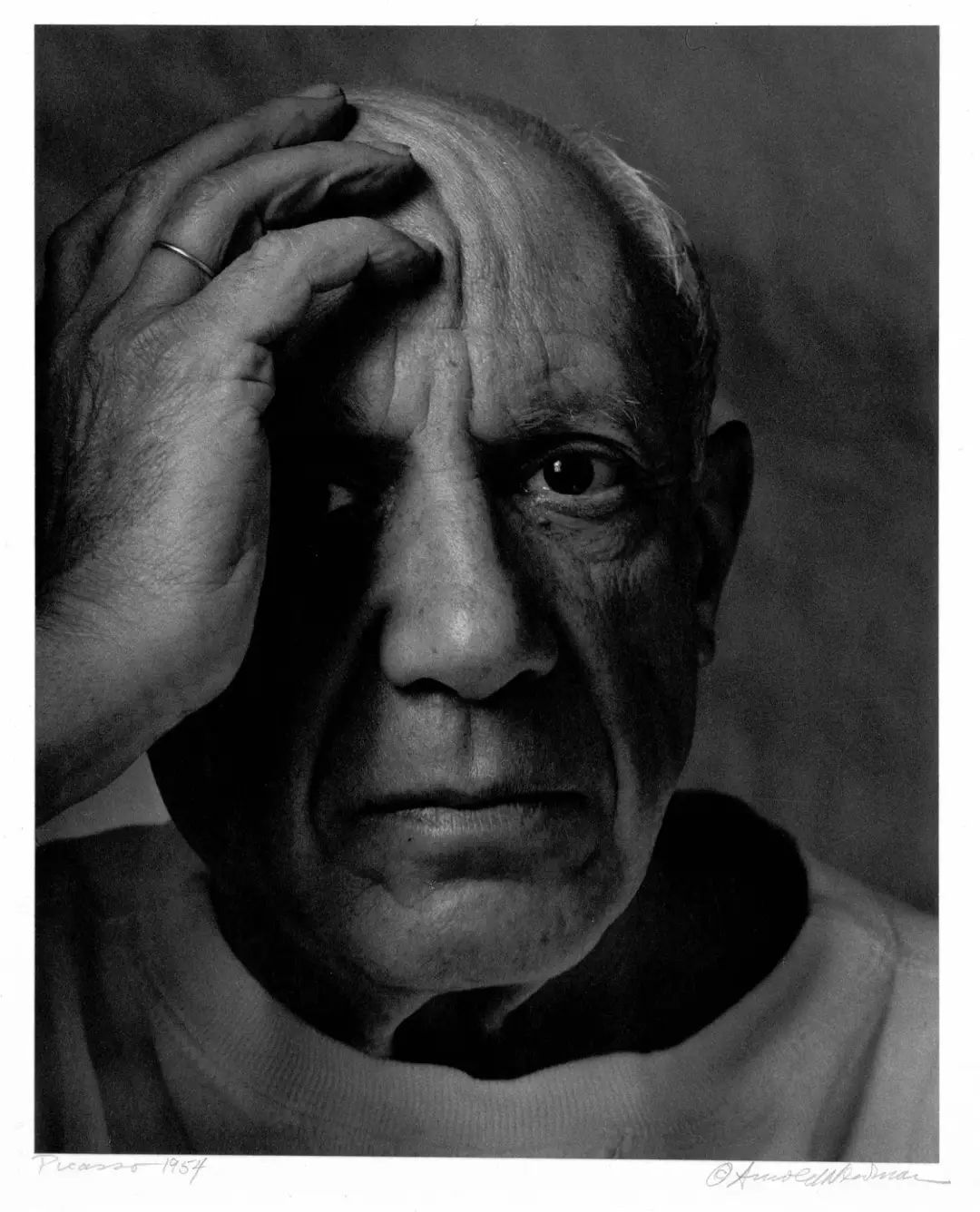

某些时候,甚至连颜色都是次要的,仅靠明暗动态范围依然能呈现出丰富的信息|Arnold Newman

而苹果在这个时候选择跳出已经白热化的分辨率、焦距和影调之争,开始通过自研图像传感器的方式为更基础的影像科学作技术积累,目的肯定不止有 iPhone 的拍照和录像,同时也是在为未来的 AR 布局——

毕竟只有当 Vision Pro 的摄像头捕捉到接近人眼动态范围的信息时,才有可能在经过处理器压缩和显示屏重现之后,给佩戴者的眼睛播放出更接近现实的画面,而不是给人看视频的错觉。

图|Cult of Mac

不过,在未来的两三年里,苹果的产品线里,最先吃上自研图像传感器红利的,肯定还是 iPhone ——或许 2027 年的 iPhone 20 上,就能拍出字面意义上所见即所得的影像了。

《惊变 28 年》片场挂着电影镜头「吕布骑狗」的 iPhone 15 Pro Max|MacRumors

文|马扶摇